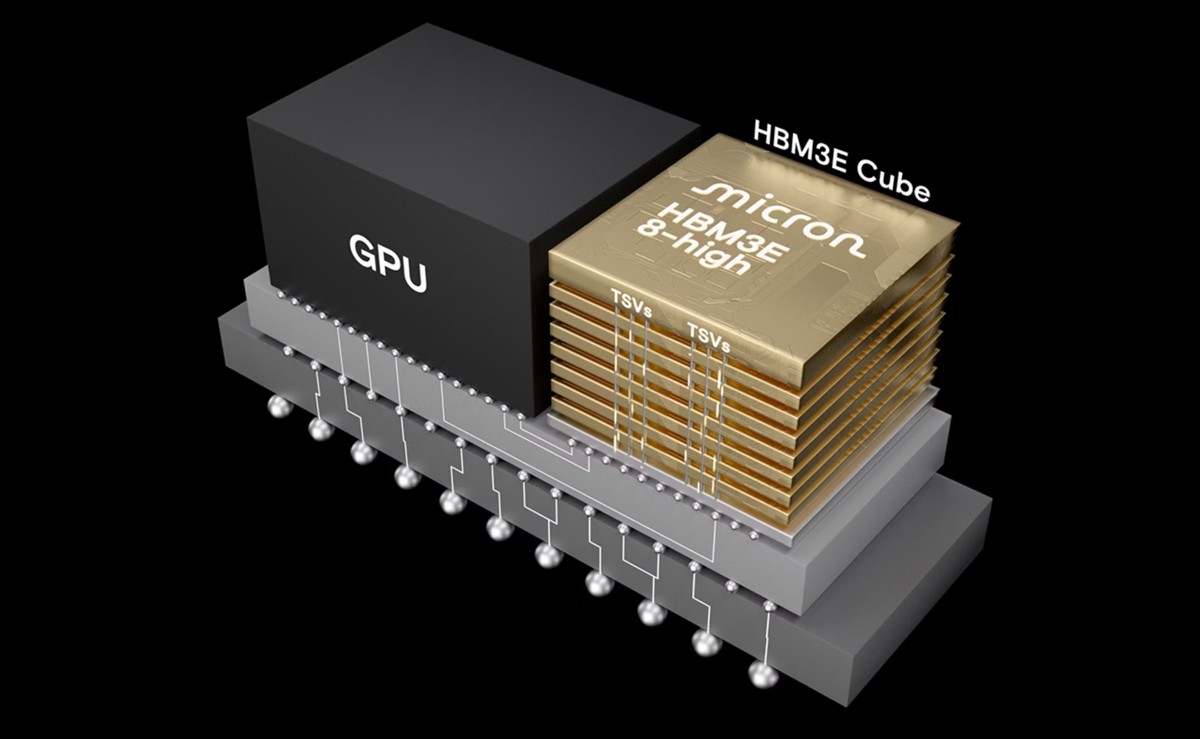

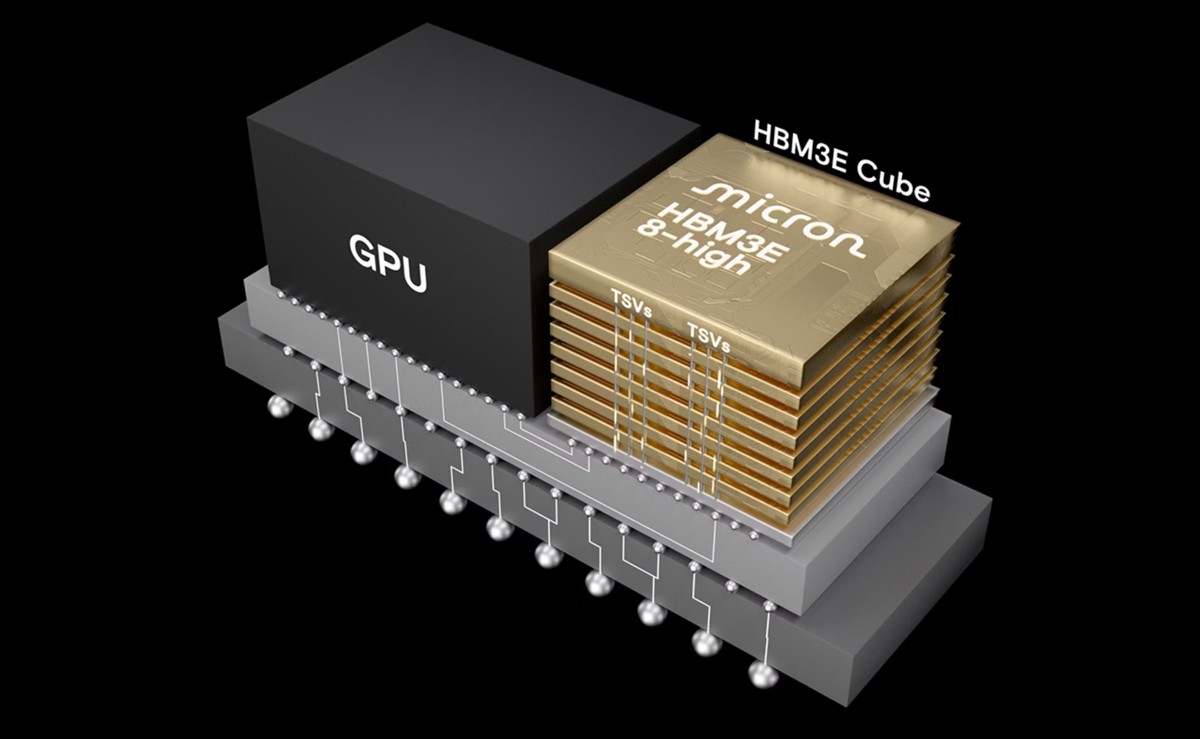

美光科技今日宣布將其 HBM3E 12 層堆疊 36GB 記憶體整合至即將推出的 AMD Instinct™ MI350 系列解決方案中。此次合作突顯能源效率和效能在訓練大型 AI 模型、提供高傳輸量推論,以及處理複雜之高效能運算工作負載 (如資料處理和運算建模)方面的關鍵作用。此外,這也是美光在 HBM 產業領導地位的另一重大里程碑,展現美光穩健的執行力和強大的客戶關係。

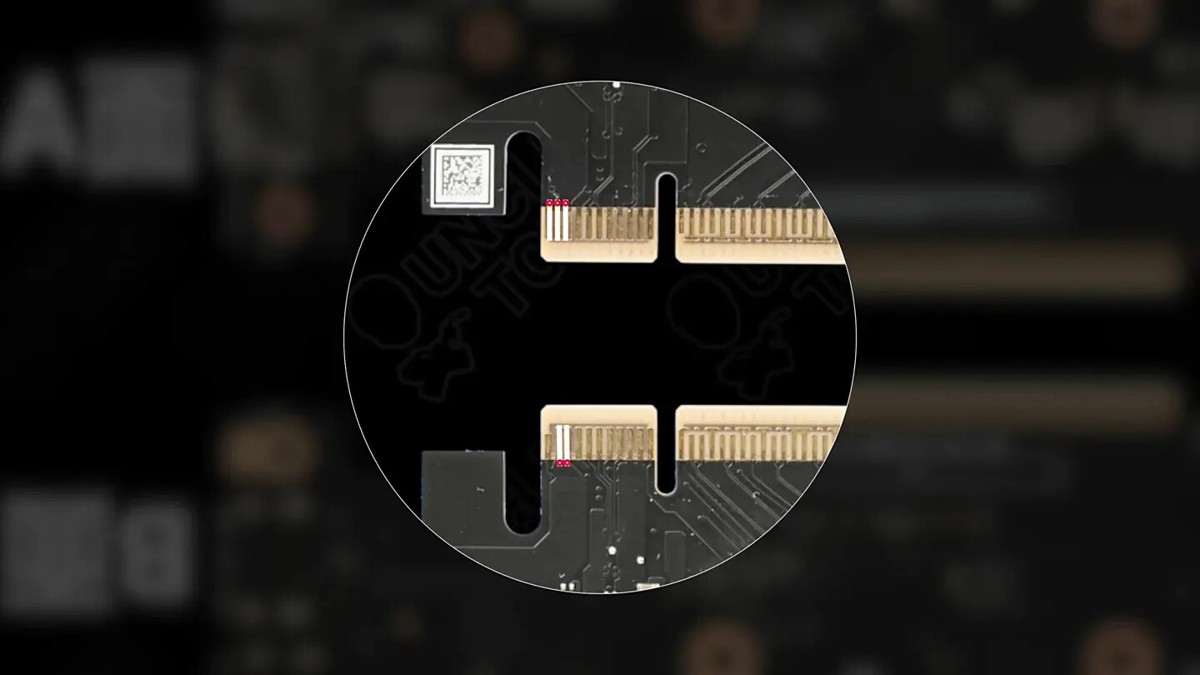

美光 HBM3E 12 層堆疊 36GB 記憶體解決方案為 AMD Instinct™ MI350 系列 GPU 平台帶來領先業界的記憶體技術,提供卓越的頻寬表現和更低的功耗[1]。AMD Instinct MI350 系列 GPU 平台採用 AMD 先進的 CDNA 4 架構,整合 288GB 高頻寬 HBM3E 記憶體,可提供高達 8 TB/s 的頻寬,實現優異的吞吐量。憑藉如此龐大的記憶體容量,Instinct MI350 系列 GPU 可在一顆 GPU 上高效支援高達 5,200 億個參數的 AI 模型。在完整平台配置中,Instinct MI350 系列 GPU 可搭載高達 2.3TB 容量的 HBM3E 記憶體,並在 FP4 精度下實現高達 161 PFLOPS 的峰值理論效能,具備頂尖的能源效率和可擴充性,適合高密度 AI 工作負載。如此緊密整合的技術架構,與具高能源效率的美光 HBM3E 記憶體相輔相成,為大型語言模型訓練、推論和科學模擬任務提供卓越的傳輸效能,不僅有助資料中心順暢無礙的擴展,更能達成每瓦運算效能的極大化。美光和 AMD 攜手合作,有效縮短了 AI 解決方案的上市時間。

美光副總裁暨雲端記憶體產品事業群總經理 Praveen Vaidyanathan 表示:「透過美光與 AMD 的緊密合作和共同在工程技術開發的努力,我們最佳化了 HBM3E 12 層堆疊 36GB 記憶體與 Instinct MI350 系列 GPU 和平台的相容性。美光 HBM3E 的產業領導地位和技術創新能為終端客戶提供更優異的總體擁有成本(TCO) 效益,並為要求苛刻的 AI 系統實現高效能。」

AMD Instinct 產品工程企業副總裁 Josh Friedrich 指出:「美光 HBM3E 12 層堆疊 36GB 記憶體是促成 AMD Instinct™ MI350 系列加速器達到卓越效能與能源效率的關鍵助力。我們與美光的持續合作推動了低功耗、高頻寬記憶體的發展,協助客戶訓練更大的 AI 模型、加快推論速度並處理複雜的 HPC 工作負載。」

美光 HBM3E 12 層堆疊 36GB 記憶體現已通過多個領先 AI 平台的認證。有關美光 HBM 產品組合的更多資訊,請造訪:高頻寬記憶體 | 美光科技。

記憶體與儲存解決方案領導廠商 美光科技(Micron Technology, Inc.) 宣布,其最新一代 HBM3E 12 層堆疊 36GB 高頻寬記憶體,將整合至 AMD Instinct™ MI350 系列 GPU 與平台,攜手推動 AI 資料中心效能與能源效率邁向新高峰。

本次合作不僅標誌著美光 HBM 技術的又一重大里程碑,也凸顯在訓練大型 AI 模型、進行高吞吐量推論及處理高效能運算(HPC)等工作負載時,記憶體頻寬與功耗表現的重要性。

[1]資料速率測試的估算是根據在製造測試環境中進行的接腳速度 shmoo 圖所得到的結果。功耗和效能估算則是基於工作負載使用情境。

美光 HBM3E 12 層堆疊 36GB 記憶體解決方案為 AMD Instinct™ MI350 系列 GPU 平台帶來領先業界的記憶體技術,提供卓越的頻寬表現和更低的功耗[1]。AMD Instinct MI350 系列 GPU 平台採用 AMD 先進的 CDNA 4 架構,整合 288GB 高頻寬 HBM3E 記憶體,可提供高達 8 TB/s 的頻寬,實現優異的吞吐量。憑藉如此龐大的記憶體容量,Instinct MI350 系列 GPU 可在一顆 GPU 上高效支援高達 5,200 億個參數的 AI 模型。在完整平台配置中,Instinct MI350 系列 GPU 可搭載高達 2.3TB 容量的 HBM3E 記憶體,並在 FP4 精度下實現高達 161 PFLOPS 的峰值理論效能,具備頂尖的能源效率和可擴充性,適合高密度 AI 工作負載。如此緊密整合的技術架構,與具高能源效率的美光 HBM3E 記憶體相輔相成,為大型語言模型訓練、推論和科學模擬任務提供卓越的傳輸效能,不僅有助資料中心順暢無礙的擴展,更能達成每瓦運算效能的極大化。美光和 AMD 攜手合作,有效縮短了 AI 解決方案的上市時間。

美光副總裁暨雲端記憶體產品事業群總經理 Praveen Vaidyanathan 表示:「透過美光與 AMD 的緊密合作和共同在工程技術開發的努力,我們最佳化了 HBM3E 12 層堆疊 36GB 記憶體與 Instinct MI350 系列 GPU 和平台的相容性。美光 HBM3E 的產業領導地位和技術創新能為終端客戶提供更優異的總體擁有成本(TCO) 效益,並為要求苛刻的 AI 系統實現高效能。」

AMD Instinct 產品工程企業副總裁 Josh Friedrich 指出:「美光 HBM3E 12 層堆疊 36GB 記憶體是促成 AMD Instinct™ MI350 系列加速器達到卓越效能與能源效率的關鍵助力。我們與美光的持續合作推動了低功耗、高頻寬記憶體的發展,協助客戶訓練更大的 AI 模型、加快推論速度並處理複雜的 HPC 工作負載。」

美光 HBM3E 12 層堆疊 36GB 記憶體現已通過多個領先 AI 平台的認證。有關美光 HBM 產品組合的更多資訊,請造訪:高頻寬記憶體 | 美光科技。

記憶體與儲存解決方案領導廠商 美光科技(Micron Technology, Inc.) 宣布,其最新一代 HBM3E 12 層堆疊 36GB 高頻寬記憶體,將整合至 AMD Instinct™ MI350 系列 GPU 與平台,攜手推動 AI 資料中心效能與能源效率邁向新高峰。

本次合作不僅標誌著美光 HBM 技術的又一重大里程碑,也凸顯在訓練大型 AI 模型、進行高吞吐量推論及處理高效能運算(HPC)等工作負載時,記憶體頻寬與功耗表現的重要性。

[1]資料速率測試的估算是根據在製造測試環境中進行的接腳速度 shmoo 圖所得到的結果。功耗和效能估算則是基於工作負載使用情境。